Det snakkes mye om at kunstig intelligens og maskinlæring krever ganske store mengder energi og dermed kan ha negative konsekvenser for klimaet – selvfølgelig litt avhengig av hvor strømmen kommer fra.

- Ikke klimaskam deg over å bruke Copilot, men...

Nå har forskere ved AI-oppstartsselskapet Hugging Face og Carnegie Mellon University undersøkt hvor mye energi som faktisk trengs for å bruke AI til å utføre ulike oppgaver. Det skriver MIT Technology Review.

Ifølge rapporten kreves det like mye energi å få generert ett AI-generert bilde, som det kreves for å lade opp en mobiltelefon. Dette er vel å merke for de minst effektive AI-modellene.

Å få en AI til å generere tekst er mye mindre energikrevende: Den mest effektive AI-modellen kan generere tekst 1000 ganger, og likevel ikke bruke mer energi enn 16 prosent av en fulladet telefon.

Trening av modellene ikke det største problemet

Forskerne skriver i rapporten at tidligere undersøkelser av eventuelle klimakonsekvenser av maskinlæring har fokusert på energiforbruk og karbonavtrykket forbundet med selve treningen av modellene.

Det er ifølge rapporten helt riktig at trening av maskinlæringsmodeller krever enormt mye mer energi enn selve bruken av modellene etterpå. For eksempel måtte man bruke Hugging Face' AI-modell BLOOM mer enn 590 millioner ganger før man hadde nådd samme karbonavtrykk som for trening av modellen.

Likevel utgjør treningen av de aller mest populære maskinlæringsmodellene bare en ganske liten del av det totale karbonavtrykket, rett og slett fordi de brukes så mye.

For veldig populære modeller som ChatGPT tar det bare et par uker med bruk før karbonutslippene for bruken overgår det som ble brukt for trening av modellen.

Store AI-modeller blir trent bare én gang, men kan bli brukt mange milliarder ganger. MIT Technology Review viser til estimater som viser at populære modeller som ChatGPT kan ha opptil 10 millioner brukere om dagen. Og hver bruker stiller gjerne mange spørsmål til modellen.

- Nettet slipper ut like mye som fly

Tekst er enklere

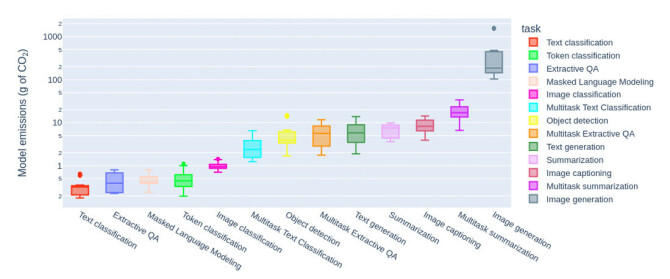

Forskerteamet så på utslipp forbundet med ti vanlige AI-oppgaver på Hugging Face-plattformen, som for eksempel å stille spørsmål, få generert tekst, klassifisering av bilder, samt å skape nye bilder.

Eksperimentene ble kjørt på 88 ulike modeller, og det ble brukt 1000 prompts for hver modell. Energiforbruket ble målt med et verktøy forskerne hadde utviklet, som de kalte Code Carbon. Denne skal se på hvor mye energi datamaskinen forbruker når modellen kjøres.

– Den minst effektive bildegenereringsmodellen bruker like mye energi som 950 mobiltelefon-ladinger (11,49 kWh), eller nesten 1 lading per bildegenerering, heter det i rapporten.

Å lade opp en mobiltelefon krever rundt 12 watt-timer, det vil si 0,012 kWh.

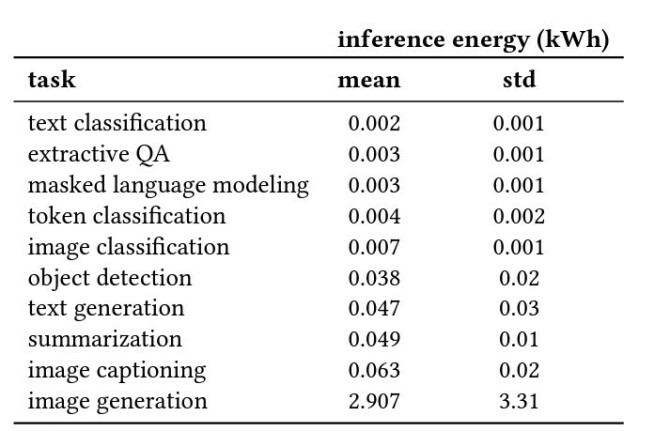

Forskerne har laget en tabell med gjennomsnittlig forbruk for ti ulike oppgaver, målt i kWh for 1000 forespørsler. I denne oversikten er riktignok strømforbruket mye mindre enn de 11,49 kilowattimene som blir nevnt i teksten:

2,907 kWh for 1000 forespørsler, eller 0,0029 kWh for 1 forespørsel utgjør såvidt vi forstår bare rundt én fjerdedel av en mobillading – hvis én mobillading er 0,012 kWh.

Men det kan antagelig forklares med at de viser til den minst effektive bildegenereringsmodellen når de bruker eksempelet med at 1 bilde = 1 lading.

– Det er en stor variasjon mellom bildegenereringsmodeller, avhengig av størrelsen på bildene de genererer, skriver forskerne.

Forskerne påpeker at det kreves mye mindre energi for tekstbaserte oppgaver. Generative oppgaver, som å skape nye bilder eller ny tekst, bruker også i snitt ti ganger mer energi enn klassifisering av bilder eller tekst.

Det å bruke AI-modeller som er finjustert for én bestemt oppgave er også mye mindre energikrevende enn å bruke generative AI-modeller som er laget for å være god på mange forskjellige oppgaver.