Ville du gjenkjent stemmene til dine nærmeste gjennom telefonen?

En mor fra den amerikanske delstaten Arizona trodde det, men hun ble lurt av en AI-stemme til å tro at datteren var i nød.

Stemmen i andre enden av telefonrøret var skremmende lik datterens. Hun trodde en mann ringte henne og truet med å ta datteren dersom hun ikke betalte ham penger, men det var bare en AI-klonet stemme, og bortføringstrusselen var falsk.

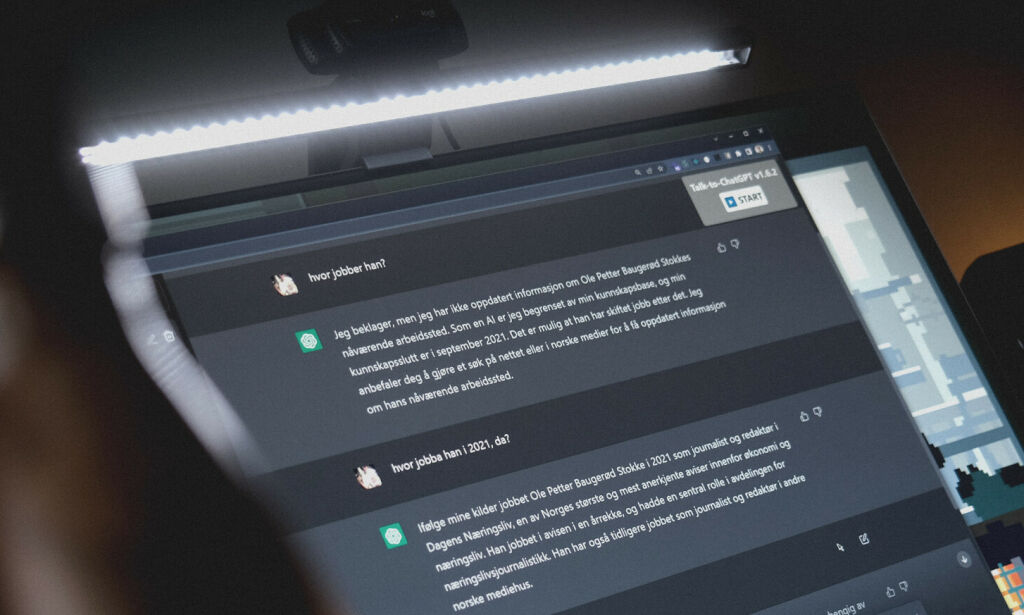

Hackere stjeler ChatGPT-en din

100 prosent overbevist

– Hjelp meg, mor. Vær så snill, hjelp meg, lød det fra telefonen.

Jennifer DeStefano var 100 prosent sikker på at stemmen tilhørte hennes 15 år gamle datter, som på det tidspunktet var bortreist på skiferie.

– Jeg stilte aldri spørsmålet «hvem er dette?», for jeg var jo helt sikker. Det var akkurat som hennes stemme, det var slik hun ville grått, sier DeStefano.

– Jeg var ikke i tvil ett sekund.

Innringeren som tok over telefonen, krevde 1 million dollar, tilsvarende nesten 11 millioner norske kroner, mot å levere datteren tilbake.

«Svindlere kan legge til ulike dialekter eller aksenter, kjønn og andre kjennetegn ved en persons stemme.»

Lettere for svindlere

Det tok heldigvis ikke lang tid før uroen la seg for DeStefano. Hun fikk omsider kontakt med datteren som var trygg, og hun skjønte at hun var forsøkt lurt.

Saken, som nå etterforskes av politiet, belyser en konsekvens av den nye teknologien der svindlere kan bruke AI-kloner av folks stemmer til å bedra.

– AI-gjenskapte stemmer, som nå ikke er til å skjelne fra faktiske menneskers stemmer, gjør det mulig for svindlere å hente inn informasjon fra ofre mer effektivt, sier Wasim Khaled, som er sjef for Blackbird AI.

Google advarer egne utviklere mot Bard

AI kan misbrukes

Ved et enkelt søk på internett finner man drøssevis av apper – mange av dem gratis – som kan brukes til å lage AI-stemmer kun ved hjelp av en liten lydfil. Et menneskes stemme kan enkelt hentes fra innlegg postet på nettet.

– Ved en liten lydfil kan AI brukes til å lage lydmeldinger. Det kan også brukes i en direkte telefonsamtale, sier Khaled.

– Svindlere kan legge til ulike dialekter eller aksenter, kjønn og andre kjennetegn ved en persons stemme. Teknologien gjør det mulig å lage overbevisende falskheter, legger han til.

«Det høres akkurat ut som barnebarnet ditt. Hvordan er det mulig? Stemmekloning, er svaret.»

Rammer besteforeldre

I en undersøkelse svarer én av fire at de eller noen de kjenner har opplevd et svindelforsøk der en AI-stemme har ringt dem.

70 prosent sier at de ikke med sikkerhet ville klart å høre forskjell på en klonet og en faktisk stemme. Undersøkelsen ble gjort på 7000 personer fra hele verden og gjennomført av McAfee Labs.

I USA har myndighetene advart om økningen i det de kaller for «besteforeldre-svindel» – der svindlerne utgir seg for å være noens barnebarn i en stresset situasjon for å få overført penger.

– Du får en telefon. I andre enden er det panikk i stemmen. Det er barnebarnet ditt som sier at han har en krise. Han har ødelagt en bil og er i fengsel, men du kan hjelpe han dersom du gir ham penger, heter det i advarselen fra myndighetene.

– Det høres akkurat ut som barnebarnet ditt. Hvordan er det mulig? Stemmekloning, er svaret, skriver de.

Bytta ut prest med AI: - Ingen følelser

– Kan ramme alle

Flere eldre har rapportert at lignende svindelforsøk har rammet dem. I Chicago fikk bestefaren til 19 år gamle Eddie en telefon fra en som lød akkurat som ham, og sa at han trengte penger etter en bilulykke.

Stemmen var så lik at bestefaren begynte å skrape sammen det han hadde av midler og vurderte til og med å ta ut nytt lån på huset, ifølge McAfee Labs. Heldigvis ble svindelforsøket avdekket før den tid.

– Fordi det nå er såpass enkelt å gjenskape realistiske stemmer, kan nesten hvem som helst som har lydklipp av seg selv på nettet, være sårbare for slike svindelforsøk, sier professor Hany Farid i informatikk ved US Berkeley.

– Disse svindlermetodene fungerer, og de sprer seg.

«Vi kommer til å trenge ny teknologi.»

Emma Watson brukt i Hitler-spøk

Tidligere i år sa det nyoppstartede KI-selskapet ElevenLabs at stemmekloningsverktøyet deres kunne bli misbrukt til ondsinnede formål.

Innrømmelsen kom etter at teknologien deres ble brukt til å gjenskape skuespiller Emma Watsons stemme til å lese Adolf Hitlers «Mein Kampf».

– Vi nærmer oss raskt et punkt hvor man ikke kan stole på det vi ser på internett, sier Gal Tal-Hochberg, som er sjef for teknologi i venturefondet Team8.

– Vi kommer til å trenge ny teknologi for å vite om personen du tror du snakker med faktisk er den du snakker med.