Forskere har undersøkt hvilke språkmodeller som i en variant av Turing-testen best kunne lure deltakerne til å tro at den er menneskelig.

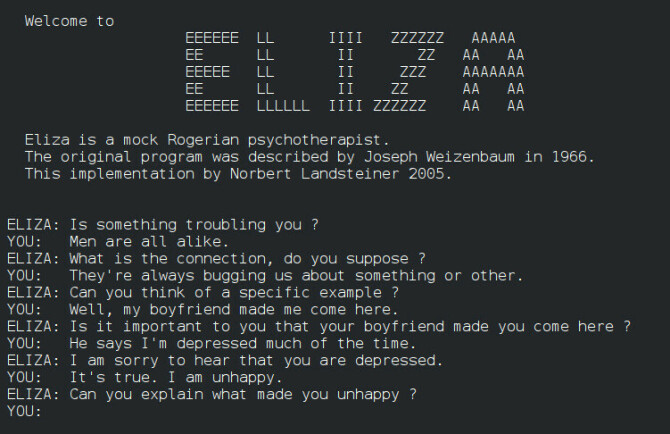

Språkmodellene i forsøket var GPT-4 og GPT-3.5 fra OpenAI, i tillegg til ELIZA, som er et samtaleprogram fra 1960-tallet, melder Ars Technica.

Forskningsartikkelen, som ikke ennå har blitt fagfellevurdert, fant at ELIZA slo GPT-3.5-modellen.

Sistnevnte er som kjent modellen bak gratisversjonen av ChatGPT.

Variant av Turing-testen

Den kjente og kontroversielle Turing-testen ble utviklet av Alan Turing i 1950.

I moderne varianter av testen snakker et menneske med et annet menneske eller en chatbot uten å hvite hvem som er fra. Klarer ikke testdeltakeren å skille chatboten fra et menneske, har chatboten bestått testen.

I dette tilfellet arrangerte forskerne en variant av Turing-testen med to spillere over internett. Formålet var å se i hvilken grad GPT klarte å overbevise deltakerne om at den var menneskelig.

Skåret bedre enn GPT-3.5

Ars Tehcnica skriver at de menneskelige deltakerne i denne testen fungerte som "avhørere" med ulike "AI-vitner" som representerte mennesker eller AI-modeller.

Overraskende nok, skriver nettavisen, fikk ELIZA en suksessrate på 27 prosent. GPT-3.5 fikk derimot bare en suksessrate på bare 14 prosent.

Kanskje ikke så overraskende var det GPT-4, med en suksessrate på 41 prosent, som var nest best - etter ekte mennesker.

ELIZA avslører seg ikke

Ars Tehcnica skriver at GPT-3.5 ikke er utviklet av OpenAI for å framstå som menneskelig. Dette kan være med på å forklare hvorfor den skåret såpass lavt i testen.

Nettavisen siterer også forskerne på at ELIZAs svar har en "tendens til å være konservative" og ikke avslører seg med å dele feilinformasjon eller "obskur kunnskap".

- ELIZA viser heller ikke tegn som mennesker i dag kobler til språkmodeller, som å være "hjelpsom, vennlig og snakkesalig". Noen av menneskene i testen rapporterte også at de trodde at ELIZA var for dårlig til å være en nåværende AI-modell, skriver forskerne.

ChatGPT ødela Turing-testen: - Et problem

Og noen forbehold

Noen forbehold må tas: Forskningsartikkelen er som sagt ennå ikke fagfellevurdert, altså har ikke andre forskere vurdert om forskningen for eksempel inneholder metodiske feil.

kode24 har også tidligere skrevet om hvordan ChatGPT og andre store språkmodeller har "ødelagt" Turing-testen. Forskere sliter rett og slett med å forstå hvordan de skal vurdere disse systemene.

Det er også dem som mener at Turing-testen ikke holder mål. Et velkjent argument er "The Chinese Room Argument". Hvis du har lyst til å nerde litt har Stanford Encyclopedia of Philosophy en lang artikkel om argumentet (og innvendingene) her.