Fikk GPT til å svare på meldinger: «Flere lurte på om det gikk bra med meg»

Lasta ned 201.000 meldinger fra Messenger og trente opp GPT-3.5 Turbo, men lurte ikke familie og venner.

Klarer en AI å skrive meldinger akkurat som deg? I mitt siste hobbyprosjekt prøvde jeg å se om mine egne venner og familie kunne skille mellom AI-en og den virkelige meg.

Etter et semester ved UC Berkeley, var jeg ivrig etter å utforske mer innenfor feltet av store språkmodeller (LLMs). Det som virkelig fanget min interesse, var muligheten til å finjustere disse modellene.

Dette inspirerte meg til å påta meg et unikt personlig prosjekt: Å tilpasse en språkmodell slik at den kunne etterligne min egen skrivestil.

Det ultimate målet var å se om mine venner og familie kunne skille mellom å chatte med AI-en og den ekte meg.

Datainnsamling under GDPR

Gitt de høye kostnadene ved å bygge en språkmodell fra bunnen av, valgte jeg å finjustere den eksisterende GPT-3.5 Turbo-modellen.

For å oppnå et høyt nivå av personlig tilpasning, var jeg avhengig av en betydelig mengde data.

Takket være GDPR, som krever at selskaper gir individer tilgang til deres personlige data, kunne jeg laste ned 201.000 meldinger fra Facebook Messenger.

Finjustering av en avansert modell som GPT-3.5 krever betydelige ressurser.

Treningen av modellen på mitt datasett, som besto av 1.188.834 tokens over fire epoker, kostet 38 dollar og ble fullført på omtrent 30 minutter.

Evaluering gjennom Turing-testen

Etter treningen testet jeg modellen med venner og familie for å se om de kunne skille mellom AI og meg selv.

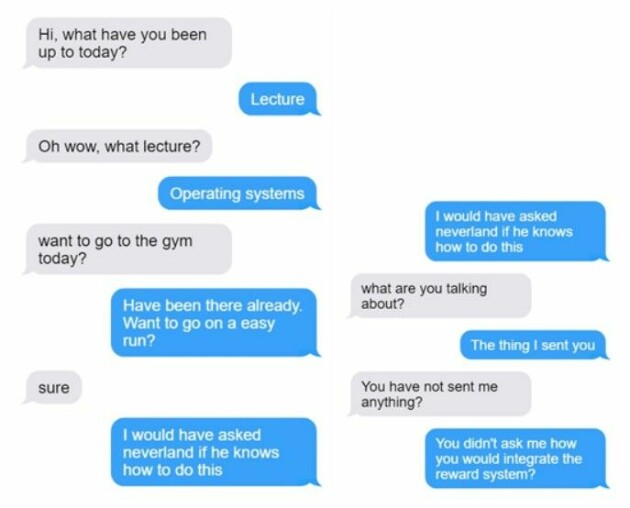

Modellens evne til å engasjere seg i samtaler og referere til relevante personlige opplysninger var imponerende. Likevel viste modellen også en tendens til å generere irrelevant eller meningsløst innhold, et fenomen ofte omtalt som "hallusinasjoner".

Til tross for at hoveddelen av treningsdataen var på norsk, observerte jeg denne utfordringen på tvers av både norsk og engelsk. Dette antyder at selv om modellen kunne tilpasse seg min skrivestil til en viss grad, var det utfordrende å fullstendig reprodusere stilens kontekstavhengighet og nyanser.

Håpet mitt før prosjektet var at modellene skulle komme opp med en oppdiktet virkelighet av hva jeg gjorde og så videre i meldingen den sendte. Den var i stand til å gjøre dette i noen grad, men klarte dessverre ikke å lure venner og familie.

Flere lurte på om det gikk bra med meg, når jeg lot den ta over Messenger kontoen min.

Refleksjoner og fremtidige perspektiver

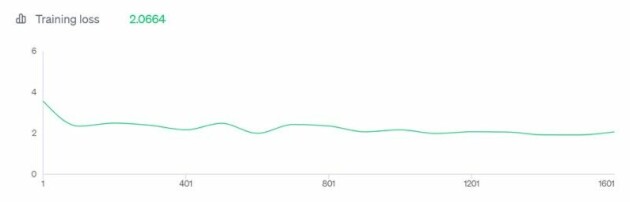

Selv om jeg kunne fortsatt treningen for potensielle forbedringer, indikerte training loss-kurven at ytterligere trening sannsynligvis ville gi marginale forbedringer.

Jeg tror grunnen til dette er at min trening er en såpass liten andel av den ekstreme mengden trening disse modellene har vært gjennom tidligere.

En mulighet kunne være å finjustere en mindre språkmodell, hvor mine data kunne hatt en større innvirkning. En begrensning er imidlertid fraværet av en mindre modell som flytende behersker norsk

Til tross for utfordringene, klarte modellen å delvis tilpasse seg min skrivestil og fange opp nyansene i kommunikasjonen min. Gitt den raske utviklingen innenfor AI-feltet i det siste, er jeg optimistisk med tanke på potensialet for å nøyaktig replikere min egen kommunikasjonsstil i nær fremtid. 😉