"Alt handler om skala nå! Spillet er over!" tvitret Nando de Freitas, en ledende forsker ved Googles DeepMind, lørdag.

Uttalelsen kom som som et svar på en meningsartikkel skrevet av Protocols AI-ekspert Tristan Greene.

I artikkelen "DeepMinds forbløffende nye ‘Gato’ AI får meg til å frykte at mennesker aldri vil oppnå AGI" argumenterer Greene for at Google DeepMinds nye AI Gato i bunn og grunn er "haug med ferdigtrente, smale modeller samlet pent", og ikke kan kalles for en kunstig generell intelligens - en AGI.

Someone’s opinion article. My opinion: It’s all about scale now! The Game is Over! It’s about making these models bigger, safer, compute efficient, faster at sampling, smarter memory, more modalities, INNOVATIVE DATA, on/offline, … 1/N https://t.co/UJxSLZGc71

— Nando de Freitas 🏳️🌈 (@NandoDF) May 14, 2022

Inspirert av språkmodellering

DeepMind-forskerens uttalelse er den dristigste som noensinne har kommet fra DeepMind om framgangen til generell kunstig intelligens, skriver Protocols Greene i en artikkel publisert mandag, der han kommenterer de Freitas uttalelse.

I et blogginnlegg forklarer DeepMind at de har vært inspirert av framskritt innnenfor storsskala språkmodellering, og brukt en lignende tilnærming for å bygge Gato.

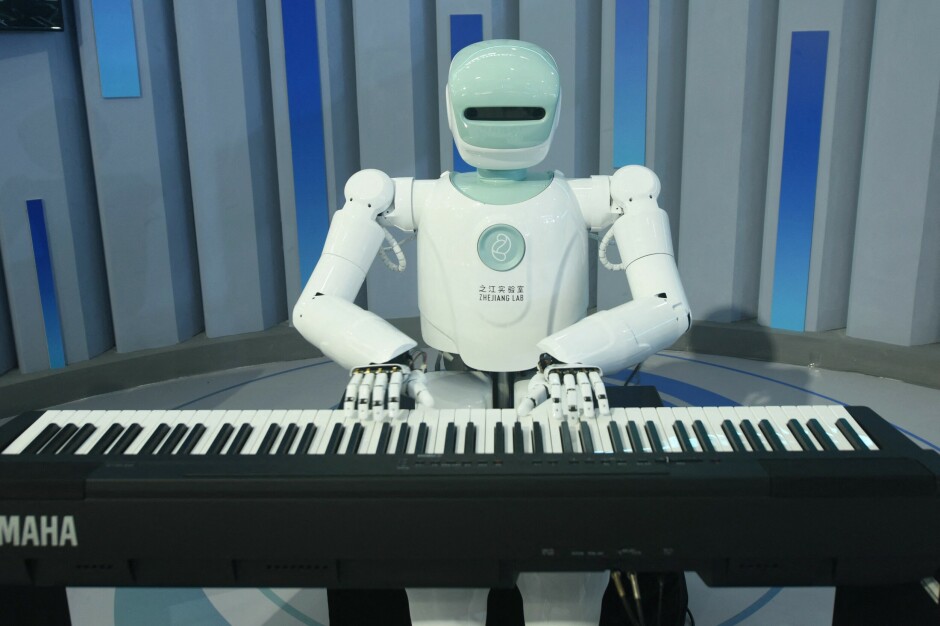

Ifølge DeepMind fungerer Gato som en multimodal og multi-oppgave generalist, som kan gjøre alt fra å spille Atari, skrive bildetekster og chatte til å stable blokker med en ekte robotarm.

Gato er lært opp på et stort antall datasett som omfatter agenterfaring i både simulerte og virkelige miljøer, i tillegg til en rekke naturlige språk- og bildedatasett.

Forskere har regnet ut sjansen for at du blir erstattet av en robot

Mener vi ikke er der

Greene er fremdeles ikke overbevist over at Gato betyr at vi på noen som helst måte nærmer oss en kunstig generell intelligens.

Han skrev på mandag at det er fort gjort å forveksle noe som Gato med generell kunstig intelligens. Forskjellen er imidlertid at en generell intelligens kan lære å gjøre nye ting uten forutgående opplæring.

Ifølge Greene er verken Gato eller konkurrenter som GPT-3 robuste nok for uhemmet offentlig bruk. Systemene krever strenge filtre for å forhindre bias, og er heller ikke i stand til å konsekvent gi solide resultater.

Dette skyldes ifølge ham ikke bare at vi ikke har funnet ut av den hemmelige kode-oppskriften bak generell kunstig intelligens, men rett og slett fordi at menneskelige problemer er vanskelige og ikke alltid har en enkel løsning.

Som et svar til de Freitas legger Greene til at det er uklart hvordan skalering, selv kombinert med banebrytende logiske algoritmer, kan løse disse problemene.