– Nasjonalmuseets samfunnsoppdrag er å formidle kunsten til alle. Det betyr at vi må lage gode løsninger også for dem som ikke kommer hit til oss, sier Tord Nilsen, utvikler og seniorrådgiver ved Nasjonalmuseet.

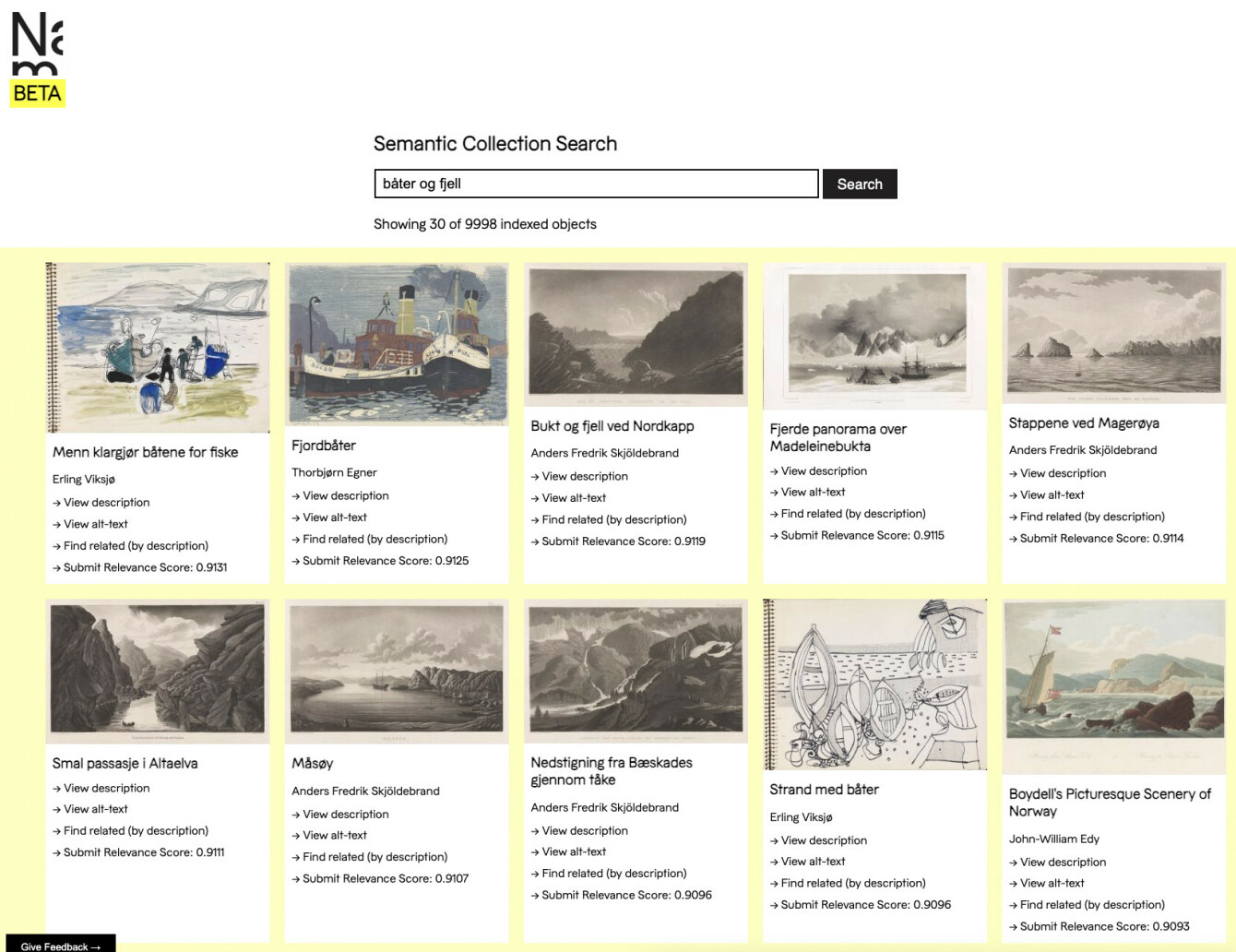

I disse dager er museet i gang med å teste ut bruk av kunstig intelligens (AI) til å lage et semantisk søk som gjør det mulig å finne frem i kunstsamlingen bare ved å beskrive hvordan kunstverket ser ut.

– Eller søke etter et selvportrett malt av samme maler som malte Skrik, uten å huske hvem som malte det. Det er veldig fascinerende!

Museet har over 400 ansatte, men det er bare to som jobber som utviklere – Tord Nilsen og Dag Hensten, som har vært utvikler hos museet i 11 år og særlig jobber med løsninger for å vise frem kunstsamlingen på nett.

Landa på OpenAI

Nilsen forteller at museet har som mål å digitalisere mest mulig av samlingen til museet – rundt 400.000 verk totalt. Foreløpig er rundt 50.000 verk gjort tilgjengelig på nett.

Med så mange kunstverk i digital form, er det selvfølgelig avgjørende med løsninger som gjør det mulig å finne frem i samlingen.

I dag kan man søke i de 50.000 kunstverkene og gjenstandene via en egen søkeside, mens prototypen på det nye semantiske søket kan testes ut på beta.nasjonalmuseet.no/collection. Foreløpig inneholder det rundt 6.000 av objektene i samlingen.

– Vi har basert søket på OpenAI sitt GPT-4 Vision-API. Vi prøvde også Lava-modellene fra Hugging Face, men de er ikke gode på malerier – selv om de er gode på foto, sier Nilsen.

Nå kan du kjøpe bibler som NFT: - Mulighet til å eie en del av historien, hevder selgeren

MongoDB Atlas

Måten søket fungerer på er at det sendes en miniatyrversjon ("thumbnail") av bildet til analyse hos OpenAI. Nilsen forteller at det har blitt jobbet mye med "prompten" som sendes til OpenAI sammen med bildet. Man ønsker nemlig ikke å få tilbake en tolkning av bildet – men en beskrivelse av hva som er på bildet.

– Vi får da tilbake en bildebeskrivelse og en alt-tekst. Så sender vi bildebeskrivelsene inn i embeddings-modellen sammen med noen av metadataene som vi allerede har på bildet, slik at vi er sikre på at vi får korrekt informasjon, forklarer Nilsen.

Embeddinger er enkelt forklart at man har tatt tekst eller bilder og konvertert til numeriske data som kan behandles av datamaskiner, og som blant annet gjør det mulig å søke etter tekst eller bilder som ligner på hverandre.

Det hele lagres i en MongoDB Atlas-database. Når brukeren søker blir spørringen konvertert til embeddinger og så gjøres det et såkalt vektorsøk i databasen for å finne ut hvilke kunstverk i databasen som er nærmest det brukeren spør om.

– Når man bruker embeddingsmodeller er man språkuavhengig. Det vil si at du kan søke på et norsk, svensk, hebraisk eller andre språk i hele samlingen vår. Bare det i seg selv er en gevinst!

«De har muligens skrapet onlinesamlingen vår tidligere.»

AI kan være problematisk

Tord Nilsen forteller at det semantiske søket foreløpig er i testfasen, og at Nasjonalmuseet er veldig bevisste på at bruk av kunstig intelligens også har en del problematiske sider.

– AI kommer i en eller annen form, men så må vi se på hvor bærekraftig det er og hvilket miljøavtrykk det setter.

Nilsen understreker viktigheten av å tenke på at man bruker AI på en etisk riktig måte. Og at det som regnes for å være etisk riktig i landet AI-modellene er laget i ikke nødvendigvis behøver å være etisk riktig for oss i Norge.

– Dette er vurderinger vi gjør og ting vi er bevisste på.

– Hva med opphavsrett? Trenes AI-modeller på kunsten i Nasjonalmuseets samling?

– OpenAI sier at hvis du bruker API-et deres slik vi gjør, så trenes ikke data på det. Men de har muligens skrapet onlinesamlingen vår tidligere, og dersom de gjør slikt så bør de varsle. Der må det komme retningslinjer, slik som med AI Act, sier Nilsen.

Mens det semantiske søket baserer seg på AI-modeller som er trent på alt av bilder OpenAI tilfeldigvis har kommet over, så kan det etter hvert bli aktuelt å trene opp egne modeller på museets samling, for å få enda bedre resultater.

– Vi ser kanskje at vi etter hvert skal trene modellene på våre egne bilder, såfremt vi får avklart dette med rettighetsspørsmål. Det er viktig å huske på at dette er åndsverk, sier Nilsen.

Nasjonal-biblioteket nekter å trene AI

Svelte og egne API-er

Det er selvfølgelig ikke bare AI og semantiske søk som opptar utviklerne hos Nasjonalmuseet. Ettersom museet har bare to utviklere, må de være ganske pragmatiske med hensyn til hvilke teknologier de tar i bruk – og det brukes også en del hyllevare.

Selv om noe utviklingsarbeid er satt ut, som iOS- og Android-appen som fungerer som en virtuell museumsguide, så lages også mye selv.

– Vi har for eksempel tilgjengeliggjort samlingen vår via et eget API.

API-et er basert på FastAPI og MongoDB, og kjøres i Docker-containere.

– Jeg håper folk programmerer mye og tar det i bruk, det er veldig mye der. API-et brukes også mot egne løsninger, for eksempel inn mot appen vår, sier Nilsen.

Nilsen forteller at de i det siste også har begynt å bruke Svelte en del til å lage innhold til museets nettsider. Mesteparten av innholdet på nettsidene ligger i CMS-et Optimizely, men utviklerne ønsker ofte å presentere innhold på litt mer avanserte måter – og da tyr de gjerne til Svelte.

– Vi bruker det fordi det er enkelt å sette opp og man får raskt opp en løsning. Og så er det mange aktive brukere, og enkelt å spørre om råd om man står fast på noe.

Takler 1.000 kall i sekundet med åpen kildekode

50.000 gigapiksler, 3D, UV

Digitalisering av all kunsten er en kjempejobb som involverer mye spesialutstyr og tar mye tid. I tillegg til å digitalisere malerier, gjøres det 3D-skanninger og lages 360-graders bilder av skulpturer og andre gjenstander.

- For eksempel tas det såkalte "gigapiksel"-bilder av malerier, slik at du kan zoome inn på detaljer som knapt er synlige, som penselstrøk og krakelering i malingen.

- De største bildene er på opptil 50.000 gigapiksler og lages ved å ta mange nærbilder av maleriene, og deretter lime dem sammen til ett stort bilde som kan være mange hundre megabyte store.

- Du finner et utvalg med gigapiksel-bilder på denne siden, hvor du blant annet kan se Skrik i oppløsningen 59.171 x 73.171 piksler.

- For å kunne vise disse bildene på en nettside brukes løsningen OpenSeadragon, som lar deg zoome inn. Selve bildene hostes på en tredjeparts bildeserver skrevet i C.

– Det sitter forskere rundt om i verden og studerer detaljene i disse bildene. Vi prøver å bruke det digitale som et verktøy for å vise det du ikke kan oppleve ved å være her – å kunne se tilleggsinformasjon som er i bildene.

For å ta dette enda et steg videre har museet begynt å ta UV-bilder av malerier. Det gjør det mulig å se bak de enkelte lagene med maling og se hvordan kunstneren har endret maleriet underveis – for eksempel ved å male over noe annet.

– Hvilke planer har dere videre?

– Jeg har veldig lyst til å utforske mer hvordan vi kan klare å formidle den skjulte historien bak verkene våre. En del av verkene, som Madonna, har informasjon i bildet som vi ikke kan se uten "radarøyne", avslutter Nilsen.