Thordur tester hvor gode AI-modellene egentlig er – her er de beste

AI-ekspert Thordur Arnason tok Googles Gemini-lansering i løgn. Men nå har resultatene gått fra skuffende til imponerende – og han har funnet sine favoritter.

Ledige stillinger

Se alleEr virkelig de generative AI-modellene fra selskaper som OpenAI, Google, Meta og andre så gode som leverandørene skal ha det til?

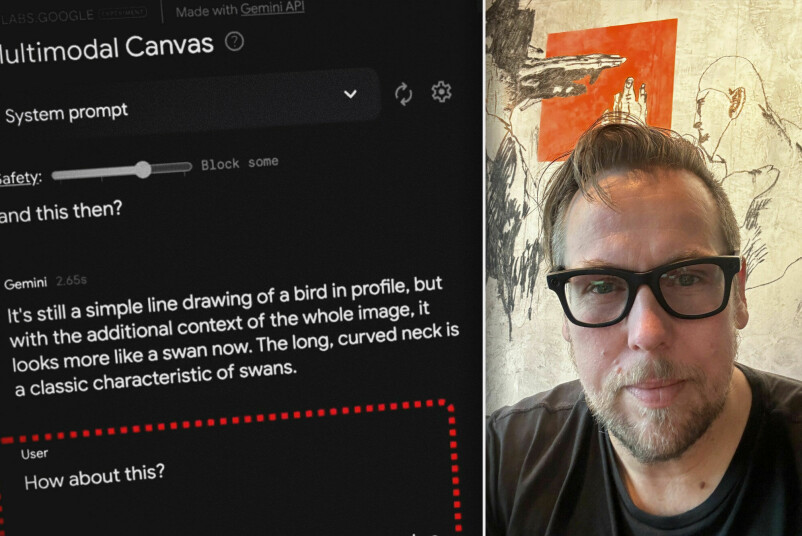

Det lurte også Thordur Arnason på da Google lanserte sin Gemini-modell for rundt ett år siden, med en imponerende demo som i ettertid viste seg å være delvis fake. I demoen skrøt Google veldig av hvor god modellen var på multimodalitet – det å kunne takle både for eksempel tekst, bilde og lyd.

– De hadde en video som så helt fantastisk ut. Men da vi og andre begynte å teste det, så var ikke modellen i nærheten av hva de viste i videoen, sier Arnason til kode24.

Arnason er Vice President og generativ AI-ekspert i konsulentselskapet Capgemini, og fikk idéen om å jevnlig teste de ledende AI-modellene for å se om de er så gode som produsentene vil ha det til – en duck-test av modellene.

Har blitt veldig mye bedre

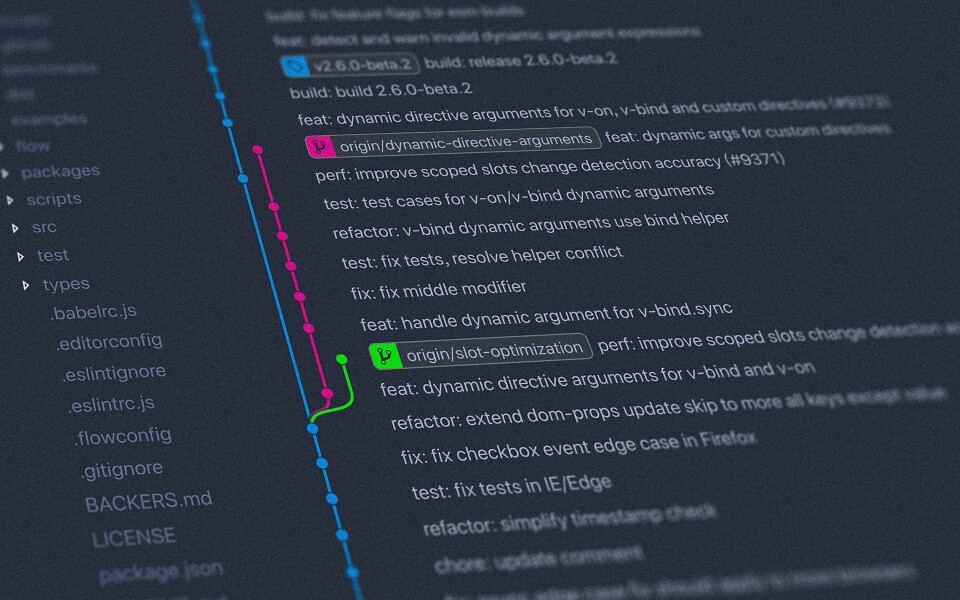

Arnason lagde et rammeverk for å teste hvor kapable generative AI-modeller er i virkeligheten, og gjennom det siste året har han publisert en rekke innlegg på LinkedIn der han på en litt leken måte har utfordret modellene og testet hva de egentlig er gode for.

Her er det første innlegget, der Arnason sjekker om Googles Gemini-modell virkelig var så bra som de skulle ha det til:

I løpet av de neste månedene gjorde han en rekke lignende tester, også av andre modeller. Og utviklingen bare i løpet av det siste året har vært enorm, sier Arnason.

Her er en test av Gemini Ultra for ni måneder siden:

Og så ble det bare bedre etter hvert som nye modeller og nye versjoner av modellene kom ut.

– Nå ett år senere så sliter jeg med å utfordre modellene. De har gått fra å være skuffende, til å nå være veldig gode!

Tester det teknisk på laben

Arnason forteller at LinkedIn-innleggene er et forsøk på en populærvitenskapelig måte å illustrere hvor gode eller dårlige AI-modellene er. På "laben" gjør han imidlertid også mer tekniske tester av modellene.

– Vi begynte med testen i desember i fjor der vi tok for oss Gemini fra Google og OpenAIs GPT-4, som var det de hadde da. Og så testet vi synsmodaliteten, hvordan tolker du dette bildet jeg har lastet opp?

I starten handlet det om å etterprøve påstandene fra Google. I Googles video tegnet de opp en kontur av en and på en PostIt-lapp og spurte hva det var, før de tegnet litt til. Hvor raskt kunne modellen kjenne igjen et dyr du tegner på en PostIt-lapp?

I fjor var verken Gemini eller OpenAIS GPT-4 spesielt imponerende. Men så går månedene.

– I fjor var verken Gemini eller OpenAIS GPT-4 spesielt imponerende. Men så går månedene, og modellene blir bedre og det kommer nye modeller. Dette er en historie om hvordan multimodalitet har utviklet seg innenfor generativ kunstig intelligens.

I den siste testen hadde Arnason gitt opp å utfordre modellene, fordi de var blitt så bra. I stedet har han prøvd å utfordre OpenAIs o1-modell på modellens evne til å løse logiske oppgaver.

– Vi bruker dette når vi snakker med kunder for å vise hva modellene kan gjøre.

Disse modellene er best

– Hvilke modeller er best nå – og er det særlig forskjell mellom dem?

– På "general purpose"-modeller som er anvendelige for folk flest, koker det ned til tre modeller som er ledende:

- OpenAIs modeller (blant annet GPT-4o)

- Googles Gemini-modeller

- Antropics Claude-modeller

– Dette er de ledende frontiermodellene av foundationmodellene, men så er det mange modeller som er rett bak – som Mistral Large 2 og Llama fra Meta, sier Arnason.

Mistral er den eneste europeiske modellen som kan konkurrere med de amerikanske, ifølge Arnason.

Årsaken er de enorme ressursene som trengs og kostnadene ved å trene de store modellene. Bare treningen av neste generasjon store språkmodeller er estimert til å koste 1 – 4 milliarder dollar (11 – 44 milliarder kroner).

Alle modellene innenfor koding har ulike styrker og svakheter, også avhengig av hvilket språk du jobber med.

– Er det noen som egner seg bedre enn andre til koding?

– Alle modellene innenfor koding har ulike styrker og svakheter, også avhengig av hvilket språk du jobber med. Det vi har testet mest på koding i det siste er CodeStral fra Mistral, som er en spesialisert versjon av deres store modell for koding. Den er interessant!

– Og så er GPTo1 Mini ekstremt god til å bruke til koding.

I tillegg har Claude 3.5 vist seg å være veldig god på spesielt Python- og C++-koding, selv om den ikke er tunet spesielt for koding.

La utviklere prøve seg frem

Arnason sier at han trodde utviklingen innenfor generativ AI ville stagnere i 2024, men at utviklingen snarere tvert imot har gått raskere enn han hadde forestilt seg.

Den raske utviklingen innenfor de ulike modellene gjør også at utviklermiljøer bør være forsiktig med å låse seg til å bruke én bestemt modell når de bruker AI-baserte kodeassistenter og lignende.

Likevel ser han behovet i større utviklermiljøer for å ha kontroll på "toolingen", og at det er lettere for mindre miljøer å eksperimentere.

– Men utviklingen skjer så fort at det er smart å gi utviklere mulighet til å teste og velge forskjellige modeller avhengig av hva de jobber med, sier Arnason.